文章詳情頁(yè)

python - scrapy運(yùn)行爬蟲一打開就關(guān)閉了沒有爬取到數(shù)據(jù)是什么原因

瀏覽:79日期:2022-08-05 15:09:38

問題描述

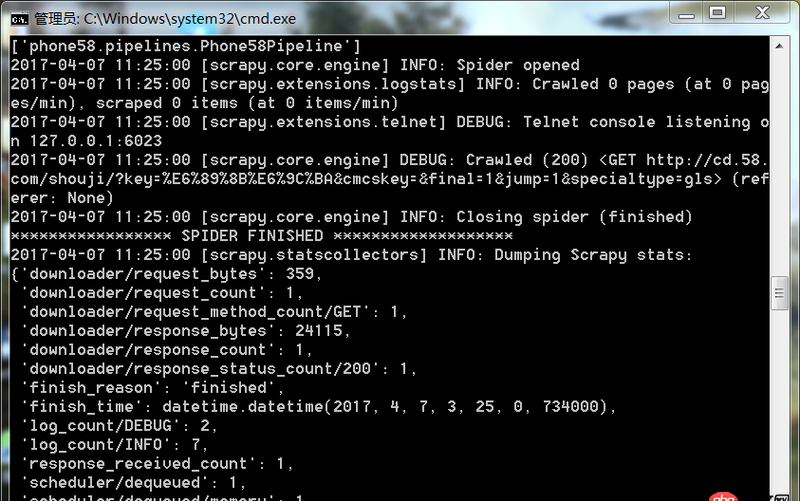

爬蟲運(yùn)行遇到如此問題要怎么解決

問題解答

回答1:很可能是你的爬取規(guī)則出錯(cuò),也就是說你的spider代碼里面的xpath(或者其他解析工具)的規(guī)則錯(cuò)誤。導(dǎo)致沒爬取到。你可以把網(wǎng)址print出來,看看是不是[]

相關(guān)文章:

1. angular.js - webpack build后的angularjs路由跳轉(zhuǎn)問題2. java - web項(xiàng)目中,用戶登陸信息存儲(chǔ)在session中好 還是cookie中好,取決于什么?3. 數(shù)組按鍵值封裝!4. mysql - navicat 經(jīng)常打開表一直在載入中 也不能關(guān)閉 著急解決5. 為什么bindClass訪問不了的?6. 我寫的哪里有錯(cuò)?請(qǐng)大神幫忙查看一下。7. 老師,怎么不講一次性添加多個(gè)數(shù)據(jù)8. 為什么 必須在<ul> 下建立 <li> 在建<a>?9. mySql排序,序號(hào)10. 這個(gè)是什么問題?

排行榜

熱門標(biāo)簽

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備