php對(duì)mysql提取數(shù)據(jù)那種速度更快

問題描述

1、單條數(shù)據(jù),即只有一行數(shù)據(jù),然后這行數(shù)據(jù)里面的字段article里面有40萬個(gè)單詞,以逗號(hào)(,)分割

2、有40萬條數(shù)據(jù),即40萬行,每行的字段article中有一個(gè)單詞

如果方案1的速度快,要怎么分別循環(huán)提取出來,然后進(jìn)行組合(以逗號(hào)分割),循環(huán)組合成40萬條,<a href='http://www.4tl426be.cn/wenda/分割后的單獨(dú)一個(gè)單詞'>分割后的單獨(dú)一個(gè)單詞</a>

問題解答

回答1:我認(rèn)為應(yīng)該是方案2的速度快。

先取1000條數(shù)據(jù):

SELECT `article` FROM `table` ORDER BY id DESC LIMIT 0,1000

對(duì)1000條數(shù)據(jù)逐個(gè)處理:

foreach ($list as $key => $value) {$link = ’<a href='http://www.4tl426be.cn/wenda/’.$value[’article’].’'>’.$value[’article’].’</a>’; ....}

再處理下面1000條

回答2:光查詢的話,前者肯定要快,但是一個(gè)字段存40W個(gè)單詞(一個(gè)單詞按7個(gè)字母算--含逗號(hào)),就是將近300W個(gè)字母,大概有3M的數(shù)據(jù)。但是查詢出來,對(duì)這么長的字段進(jìn)行切割,感覺不太靠譜。

回答3:如果是簡單的在頁面上列出40w個(gè)單詞這種業(yè)務(wù),我覺得還是第一種方法快

理由:一、查詢方法1.掃描一行就能獲取到記錄,方法2那就需要掃描很多行了,花費(fèi)的時(shí)間就不言而喻了(表越大越明顯)。這個(gè)過程方法1比方法2優(yōu)越太多了二、輸出方法1需要獨(dú)立分割,這對(duì)php來說根本不叫事。然后都需要緩存輸出。

總的來說,方法1的開銷比方法2的開銷少。

相關(guān)文章:

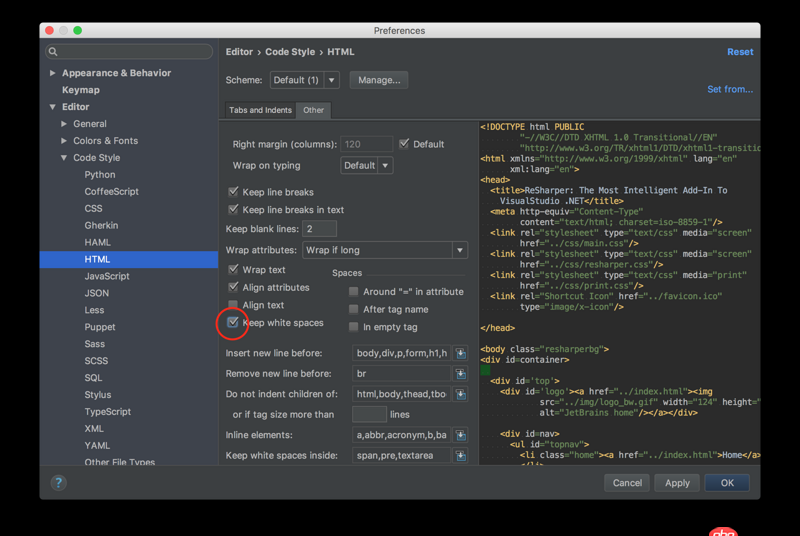

1. python文檔怎么查看?2. javascript - 有適合開發(fā)手機(jī)端Html5網(wǎng)頁小游戲的前端框架嗎?3. python - Pycharm的Debug用不了4. html - eclipse 標(biāo)簽錯(cuò)誤5. datetime - Python如何獲取當(dāng)前時(shí)間6. javascript - 關(guān)于apply()與call()的問題7. python - pycharm 自動(dòng)刪除行尾空格8. python - pandas按照列A和列B分組,將列C求平均數(shù),怎樣才能生成一個(gè)列A,B,C的dataframe9. 安全性測試 - nodejs中如何防m(xù)ySQL注入10. python 利用subprocess庫調(diào)用mplayer時(shí)發(fā)生錯(cuò)誤

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備